- 生成AIから目的に適った回答を得るには、詳細で具体的なプロンプトを与えるのが大切です。

- ただし、生成AIには一度に参照できる情報量に限界があり、会話が長くなるにつれ「脈絡のない答え」が増えてきます。

- 適切なタイミングでチャットを仕切り直して、「記憶の鮮度」を維持する工夫が有効です。

生成AIの基本的な性質について話したいと思います。

最も伝えたいことは「プロンプトとチャットの長さ」という考え方です。

YouTube動画でも話しています。

1. 生成AIとの会話の分量は長くなる

生成AIは一つ一つの指示(プロンプト)がかなり長くても理解できるようになっています。

むしろ、キーワードや短い文では「ありきたりの答え」しか返ってきません。

チャットを進めていくコツは、3つあります。

- 厳密で詳細なプロンプトを構成する

- チャットの往復を繰り返していく

- 役割を与える(プリセット プロンプト)

一度で答えを得ようとせず、やり取りの中で答えに近づいていけばいいんだね。

ゴルフみたい。

反対に、厳密なプロンプトが役立つのは、スライド作りなど決まった作業を繰り返し依頼する場合です。

AIから最適な回答を引き出すための指示文の設計技術を「プロンプトエンジニアリング」といいます。

明確な指示、具体例の提示、ステップバイステップの思考要求など、様々なテクニックを含みます。

適切にプロンプトを設計すると、AIの回答品質を大幅に向上できることがあります。

2. 生成AIは徐々に「疲れる」

ただし、ある程度チャットを続けていると、回答の内容が乱れてきます。

脈絡のない文章が混ざってくるのです。

一つのチャットでやりとりが長く続くと情報量が増え、「AIの頭の中がとっ散らかって」いきます。

そこで、適切なタイミングで新しいチャットを始める必要があります。

会議でも40分ぐらいで休憩時間を取った方がいいけど、なんか似ているね。

2.1. 記憶を整理するタイミング

「AIの記憶の鮮度」を維持するためには、必要に応じて会話を新しく始めたり、重要な情報を繰り返したりする工夫が必要です。

かんたんなコツは、新しいチャットに移行する前に、そこまでのやり取りをまとめさせることです。

この文章をコピーして新しいチャットの冒頭に送ると、かんたんに「会話の継承」ができます。

今のAIの能力では、この記憶の違いを自分で管理できないようです。

そのため、私たち人間が意識してAIの「記憶」を整理してあげると、AIをうまく活用できます。

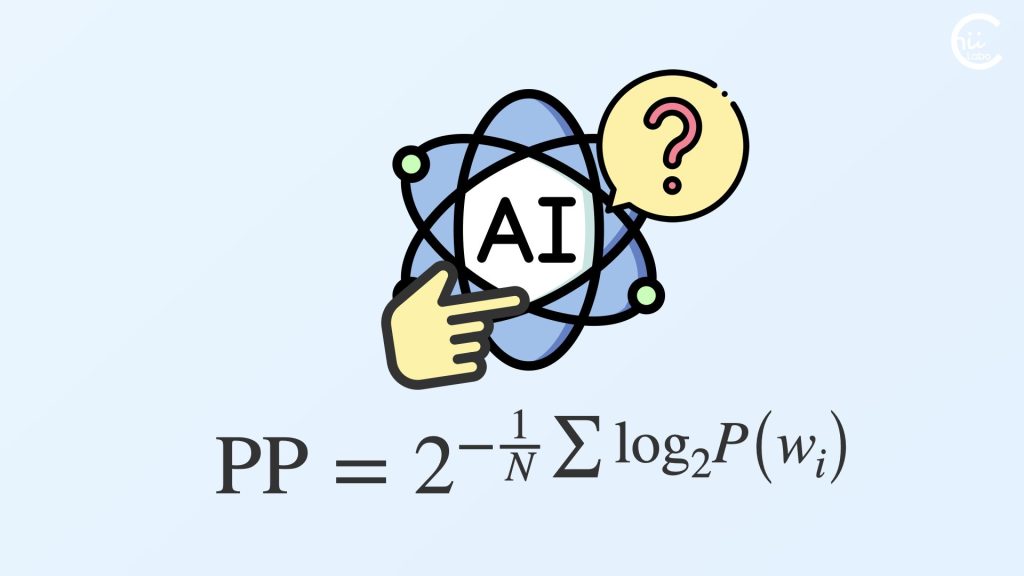

3. コンテクストウィンドウとトークン制限

この理由を技術的に補足すると、生成AIには、一度の会話で参照できる情報量の範囲があるからです。

この範囲は「コンテクストウィンドウ(Context Window)」といい、会話履歴やユーザーの指示内容などを含んだ「AIの作業記憶」と言えます。

コンテクストウィンドウには限界があり、長いの会話になるにつれ過去の情報が「薄められて」いきます。

例えば、会話の初めに与えた重要な制約や指示が、長いやり取りの後に無視されることがあります。

これは人間でいえば、短期記憶と長期記憶の違いに似ています。

事前学習データは、長期記憶のように長く保存されますが、コンテクストウィンドウは、短期記憶のように一時的なものです。

3.1. トークン制限と注意機構

ちなみに、コンテクストウィンドウの「サイズ」を規定するのは、AIモデルの「トークン制限」です。

文章や単語は「トークン(token)」という単位に分割され、モデルによって8K~100Kトークン程度の制限があります。

トークン制限が生じる理由は

- AIが動いているコンピュータの「メモリ」に限りがある

たとえば、スマホやパソコンのメモリがいっぱいになるとアプリが重くなるのと同じ。 - 単語同士の関係を計算する処理は文章量の二乗のペースで増える

AIが文章を理解する仕組み「注意機構(Attention)」では、文章の二乗に比例して計算量が増えてしまいます。

生成AIサービスの有料プランは、このトークン制限を大きくしているんだね。

「人工知能はすべての情報を記憶している」と考えますが、人間の記憶のようにふだんは「活性化していない」状態にすることで、現実的な時間で処理できるようにしています。

「トランスフォーマー」は、自然言語処理の革新的なニューラルネットワークアーキテクチャです。

2017年に「Attention is All You Need」論文で紹介され、自己注意機構(self-attention)を核心技術として、単語間の関係性を並列処理できます。

GPT、BERT、T5などの現代的な言語モデルの基盤となっており、現在の生成AIの中核技術です。