- AI(人工知能)は、学習量が多くなればどんどん賢くなると思われています。

- しかし、実際には学習するほど「おかしな回答」をする「ドリフト現象」があります。

AIの仕組みはとても複雑です。

そのため、AIの一部を良くしようとすると、別の部分の性能が下がってしまうことがあります。

学習するほど賢くなる、という単純なものじゃないんだね。

1. 「ドリフト」って何?

「ドリフト」とは、利用しているうちに AI の回答精度が下がってしまう現象です。

これは、海に浮かぶ船が、風や潮に流されてどんどん目的地から離れていくようなものです。

「ドリフト(drift)」という言葉は、本来「漂流」や「ずれ」を意味します。

AI の性能や振る舞いが、時間とともに本来の目的や設定から外れていくことを、海で船が風や潮に流されるイメージで表現しています。

1.1. AIにも「学び直し」

普通、機械学習プロジェクトは次のような流れで進みます。

まずデータを準備し、特徴を抽出し、モデルを訓練して評価します。

モデルの精度が十分になったら、本番環境で使い始めます。

でも実際には、本番環境で使い始めた後も訓練や調整は続きます。

モデルは使い続けると徐々に精度が落ちるので、新しいデータで学習し直す必要があるからです。

AIを「現実世界」に繋ぎ留めておかないとダメなんだね。

2. AIがどんどん「迷子」になっていく?

ほんとに時間が経つとAIは「バカ」になるの?

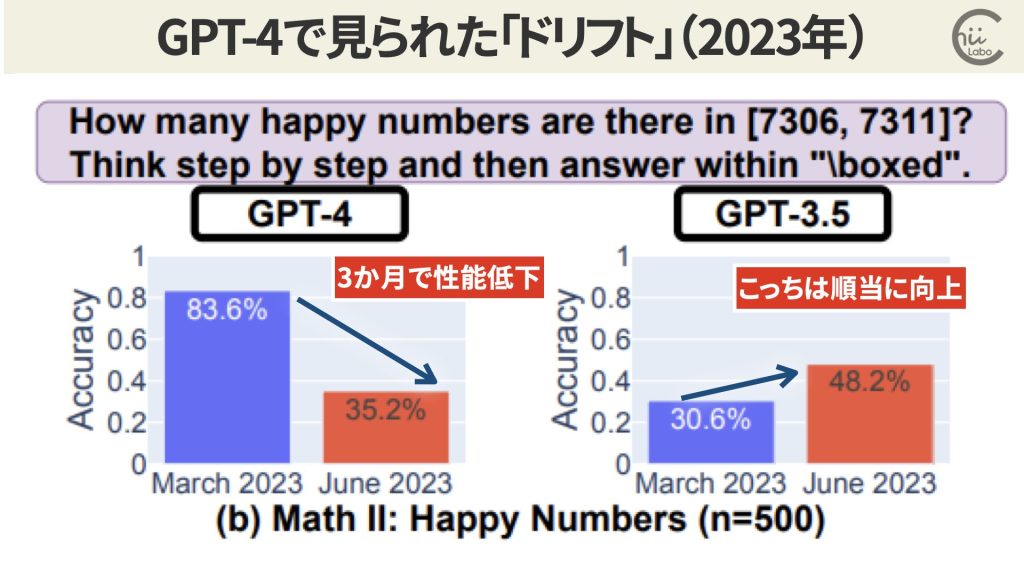

ドリフトについて有名な研究は、2023年のカリフォルニア大学とスタンフォード大学のものです1。

ChatGPTの能力が時間とともにどう変わるかを調べました。

すると、GPT-4では、3月バージョンの方が6月バージョンを上回ってしまうタスクも多かったのです。

2.1. モデル自己消費障害

また、2024年にはライス大学の研究チームが生成された画像を元に学習したAIの品質が劣化する現象を報告しています2。

![出典:[2307.01850] Self-Consuming Generative Models Go MAD](https://chiilabo.com/wp-content/uploads/2024/08/image-9-20240815-013420-1024x576.jpg)

AIが作り出した人工的なデータを使って、次世代のAIモデルを訓練する過程を繰り返すと、「モデル自己消費障害(Model Autophagy Disorder: MAD)」という循環が起こり、生成モデルの質(精度)や多様性(網羅性)が徐々に低下してしまうのです。

つまり、AIだけに任せていると、どんどん「純粋」なAIになっていって、現実世界との接点を失ってしまう可能性があるのです。

2.2. なぜドリフトが起こるの?(過学習と部分最適化)

ドリフトの主な原因は以下の3つです。

- 過学習:

特定のデータや問題に対して必要以上に詳しくなりすぎてしまうこと - 部分最適化:

ある状況に対して完璧になろうとするあまり、全体のバランスを崩してしまうこと - データの変化:

AIが学習したデータと、実際に使われる環境のデータが違ってくること

「学習」とは、経験を通して新しい知識や技術を身につけ、それを別の場面で使える力のことです。

単に情報を覚えるだけではなく、周りの状況に合わせて上手に行動できるようになる過程を指します。

しかし、AIは、特定のデータや問題に対して必要以上に適応してしまうことがあります。

これを「過学習」と呼びます。

ある状況に対して「部分最適化」されてしまい、全体のバランスを崩してしまうのです。

これは人間でもAIでも起こり得る現象です。

学んだことに固執しすぎると、かえって新しい環境にうまく対応できなくなることがあるんですね。

3. 「データドリフト」と「コンセプトドリフト」

「ドリフト」は、データドリフトとコンセプトドリフトの2種類に分類されています。

3.1. データドリフトと諸行無常

「データドリフト」は、入力データ自体の特徴が変わることです。

- 機械学習は入力データと予測結果の関係をデータから推測する方法なので、訓練データと本番データの性質が違うと、予測結果も変わってしまいます。

- また、AIが学習データに含まれる偏り(隠れたバイアス)を学習してしまい、それが時間とともに顕在化することがあります。

- さらに、「フィードバックループ」の問題があります。

AIの出力が新しい入力データとなり、それによってAIの行動が変化することがあります。

世の中の情報や傾向は常に変化しています。

AIが学習したデータと、実際に使われる環境のデータが「ズレ」てくると、回答精度が落ちてくるのです。

時間や空間が学習したところから離れていくと、AIは迷ってしまうんだね。

3.2. コンセプトドリフトと価値観の変化

「コンセプトドリフト」とは、AIが学習した概念が時間とともに変化することを指します。

これは、AIが理解しようとしている事柄の意味が、AIの訓練時と比べて変わってしまう現象です。

具体的な例として、SNS上の「迷惑投稿(スパム)」を考えてみましょう。

スパムの定義は時代とともに変化します。

以前は問題なかった投稿が、今では迷惑とみなされることがあります。

そのため、古い基準で作られたAIは、現在のスパムを正しく判断できなくなる可能性があります。

4. AIはどんどん賢くなるわけではない

ドリフトの概念は、AIの学習や性能が必ずしも線形に向上していかないことを示唆しています。

AIの学習曲線は通常、単純な直線ではありません。

- 初期の急速な向上:

学習初期には性能が急速に向上することが多い。 - プラトー期:

ある程度学習が進むと、性能向上が鈍化する期間がある。 - 突然の飛躍:

新しいデータや手法の導入で急に賢くなることもある。 - 後退期:

ドリフトにより性能が低下することもある。

AIは便利なツールですが、完璧ではありません。

時々おかしな答えをすることもあります。

だから、AIを使うときは、その答えが本当に正しいかどうか、自分でも考えてみることが大切です。

急に賢くなると同じペースでどんどん賢くなるように感じるけど、そういうものでもないんだね。

4.1. ドリフトを見つけて訓練し直している

ドリフトが起きてモデルの精度が下がったら、新しいデータで学習し直す必要があります。

学習し直したら、再び本番環境で使い始めます。

本番環境でモデルの精度を保つには、ドリフトを見つける仕組みを含めた流れで進めることが必要不可欠です。

けっこう、人の手で地道なメンテナンスがされているんだね。

(補足)

- How Is ChatGPT’s Behavior Changing over Time?(PDF)

- [2307.01850] Self-Consuming Generative Models Go MAD –

![[Excel]個人用マクロブックがロックされないように「読み取り専用」にするマクロのメリット・デメリット(ChangeFileAccess, xlReadOnly)](https://chiilabo.com/wp-content/uploads/2024/02/image-24-1024x576.jpg)

![[Electron]連続コピーアプリを作ってみた(monclip)](https://chiilabo.com/wp-content/uploads/2024/08/image-9-20240815-061607-1024x576.jpg)