AIの話題

AIの話題なぜ「良質なデータ」を選んで与えても生成AIは間違えるのか?(根底にあるパラダイム・シフト)

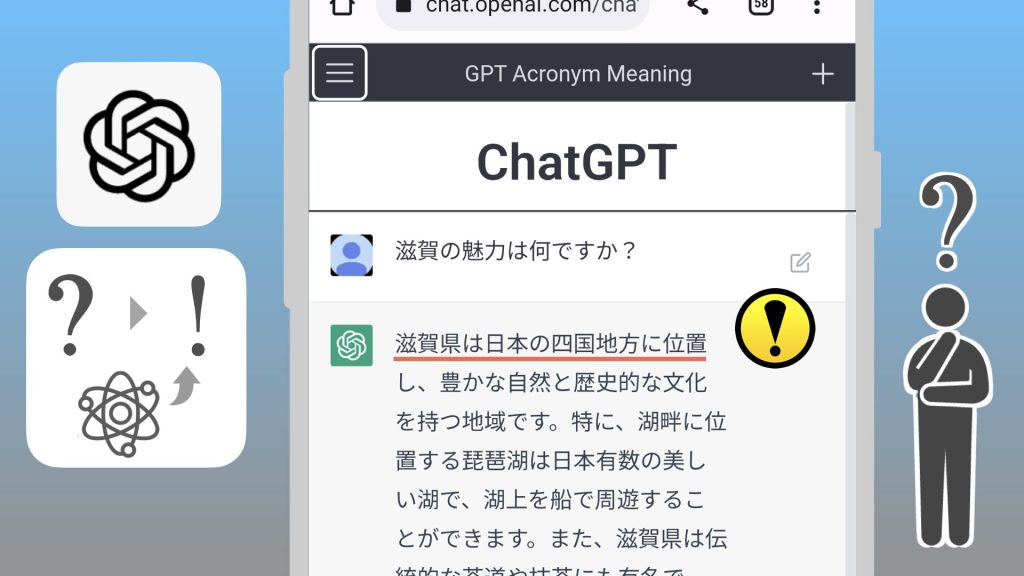

生成AIは学習した情報を断片化した上で連続的に生成するため、質の良いデータでも文脈の断絶や再構成エラーが起こり、ハルシネーションが発生しがちです。従来の「正確さ」を重視する検索パラダイムと「自然さ・創造性」を重視する生成パラダイムの間には根本的な矛盾があります。生成AIの真価は単なる「知識や情報を提供するツール」ではなく、対話的に「思考を広げ・深めるツール」として活用することにあります。YouTube動画でも話しています。なぜ良質なデータでも生成AIは賢くならないのか?会社の...