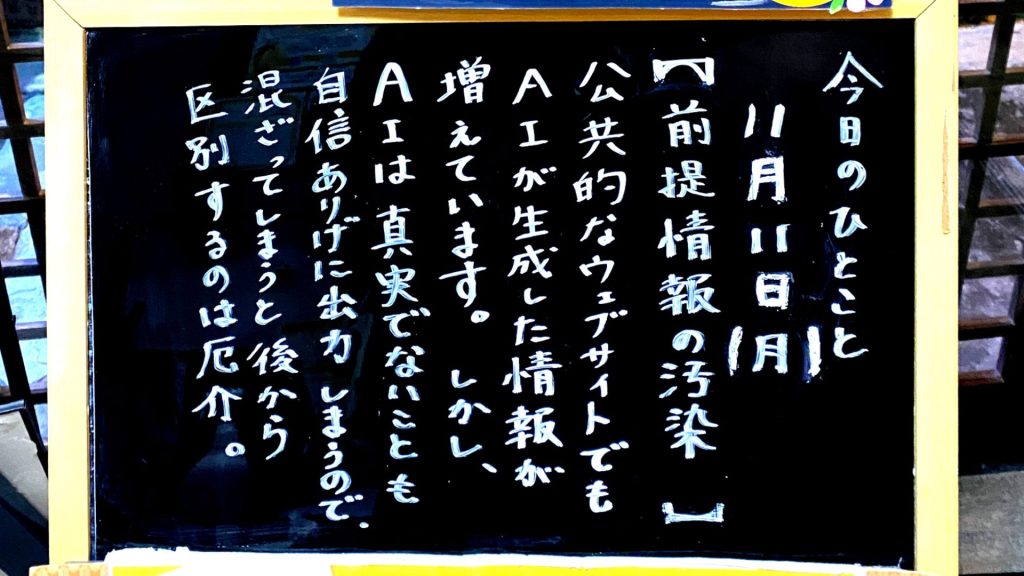

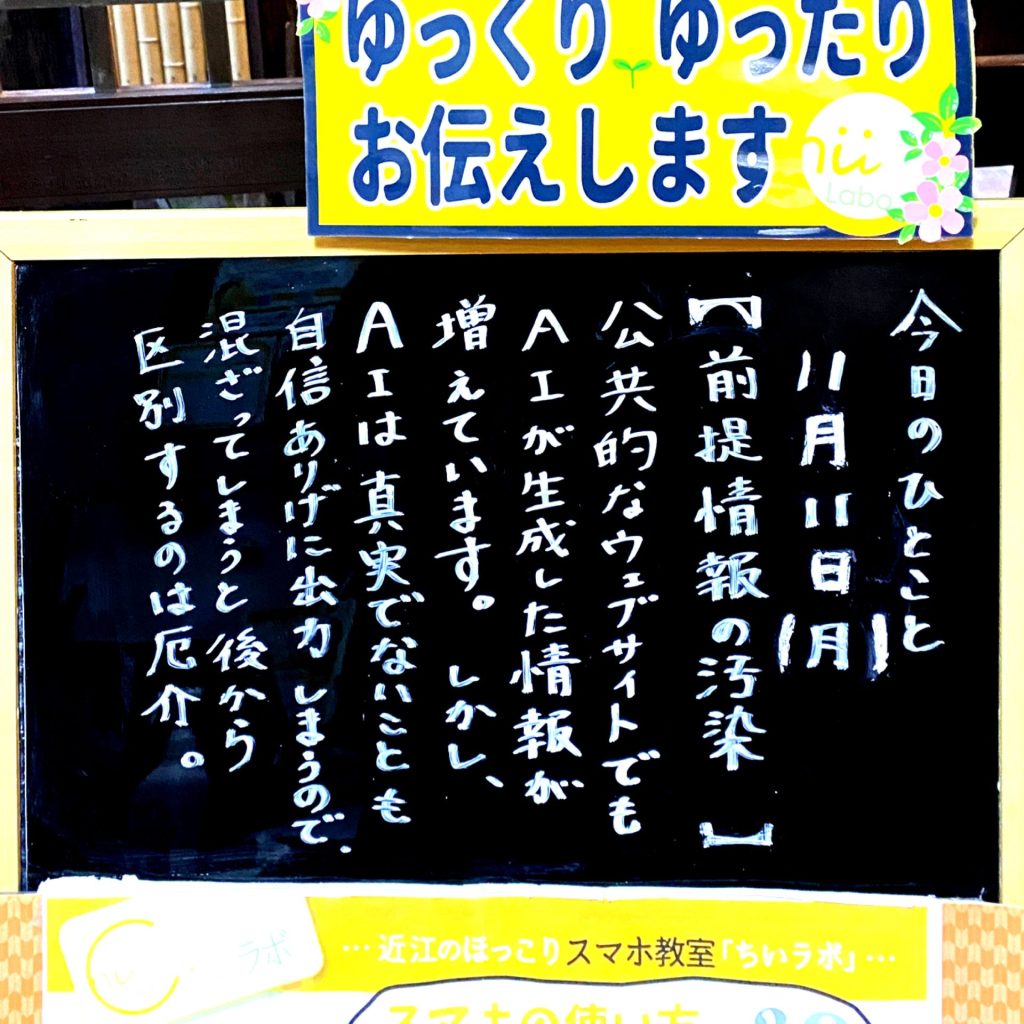

公共的なウェブサイトでも、AIが生成した情報が増えています。

しかし、AIは真実でないことも自信ありげに出力してしまいます。

混ざってしまうと、後から区別するのは厄介。

生成AIで福岡のPR記事作成→“架空の祭りや景色”への指摘が続出 開始1週間で全て削除する事態に

Webで地方の魅力をPRする「つながり応援プロジェクト」は、福岡県でのキャンペーン「福岡つながり応援」の公式Webメディアで「誤った情報を発信した」と公式Xで謝罪した。生成AIを活用してPR用の記事を制作したところ、ユーザーから間違いを指摘する声が相次いだという。

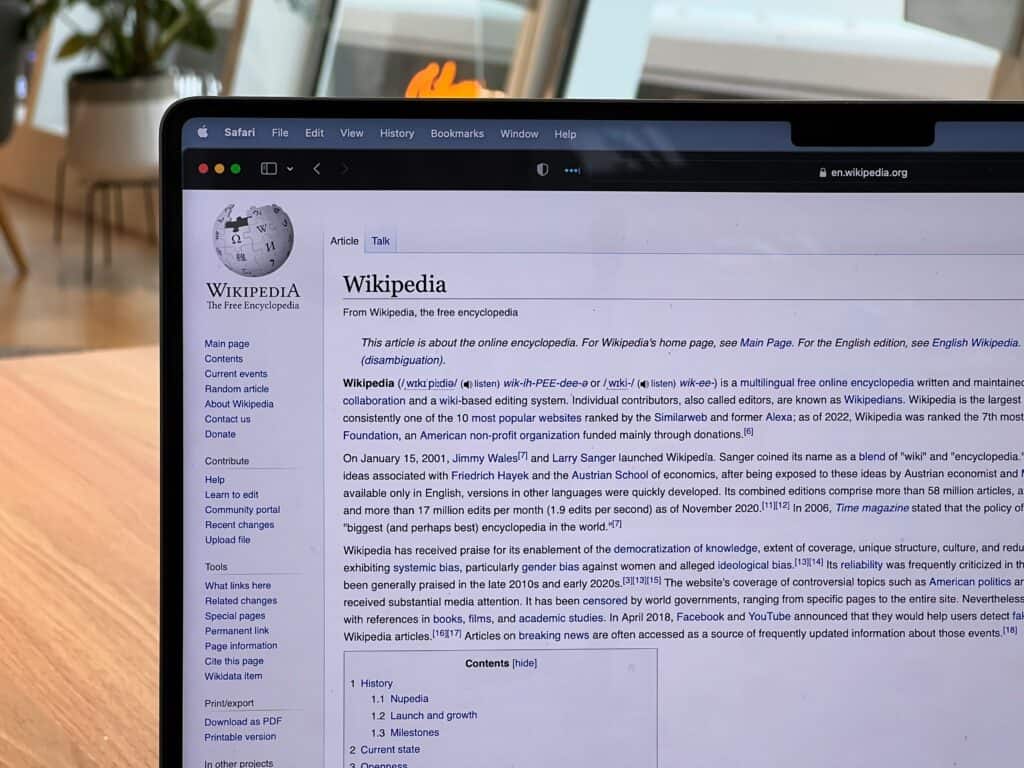

Wikipediaに増え続けるAI生成の偽情報を排除するボランティア達の静かな戦い | XenoSpectrum

インターネット上の偽情報の蔓延が深刻化する中、世界最大のオンライン百科事典であるWikipediaもその脅威に直面している。近年、人工知能(AI)による生成コンテンツがWikipediaの記事に紛れ込む事例が増加しており、信頼性の高い情報源としての地位を脅かしている。

「ハルシネーション」とは?

生成AIの「ハルシネーション」というのは、AIが学習したデータの範囲を超えて、でたらめな答えを出力してしまう現象です。人工知能が幻覚を見ているかのように回答することから名付けられました。

「ドリフト現象」とは?(漂流するAI)

AI(人工知能)は、学習量が多くなればどんどん賢くなると思われています。しかし、実際には学習するほど「おかしな回答」をする「ドリフト現象」があります。AIの仕組みはとても複雑です。そのため、AIの一部を良くしようとすると、別の部分の性能が下がってしまうことがあります。学習するほど賢くなる、という単純なものじゃないんだね。「ドリフト」って何?「ドリフト」とは、利用しているうちに AI の回答精度が下がってしまう現象です。例えば、こんな感じです:以前はきちんと答えられていた質問に...

生成AIは「正解のない問題」を聞く道具(検索との違い)

代表的な生成AIとしては、ChatGPT、Copilot、Geminiなどがあります。すごく当たり前ですが、生成AIは「生成」が必要な作業に役立ちます。生成AIを「調べもの」に使うと、「遅くて」「的外れ」な回答が多いと感じるかもしれません。しかし、対話を伝え続けると「文脈」が共有され、徐々に意図に沿った回答が得られるようになります。生成AIは、「正解のない問題」が得意です。反対に「正解がある問題」を調べるには従来の検索エンジンの方が速い面も。「生成AI」というと、「なんでも答...

推論によるスケーリング(OpenAI o1のChain of Thought)

OpenAIが発表した新しい人工知能「o1(オーワン)」は、「Chain of Thought」という推論の仕組みを使って複雑な問題を解決します。問題を小さな部分に分けて段階的に解決することで、より正確な答えを導き出すことができます。モデルサイズではなく推論時間を延長することで性能を向上させるアプローチの登場で、生成AIの世界は大きく変化する可能性があります。従来の生成AIとは違う「推論」の仕組み2024年9月12日、OpenAIは新しい人工知能「o1(オーワン)」を発表しま...

QRコードを読み込むと、関連記事を確認できます。