- 生成AIの「ハルシネーション」というのは、AIが学習したデータの範囲を超えて、でたらめな答えを出力してしまう現象です。

- 人工知能がまるで「幻覚」を見ているかのように回答することから名付けられました。

「ハルシネーション(hallucination)」の元の意味は、「幻覚」です

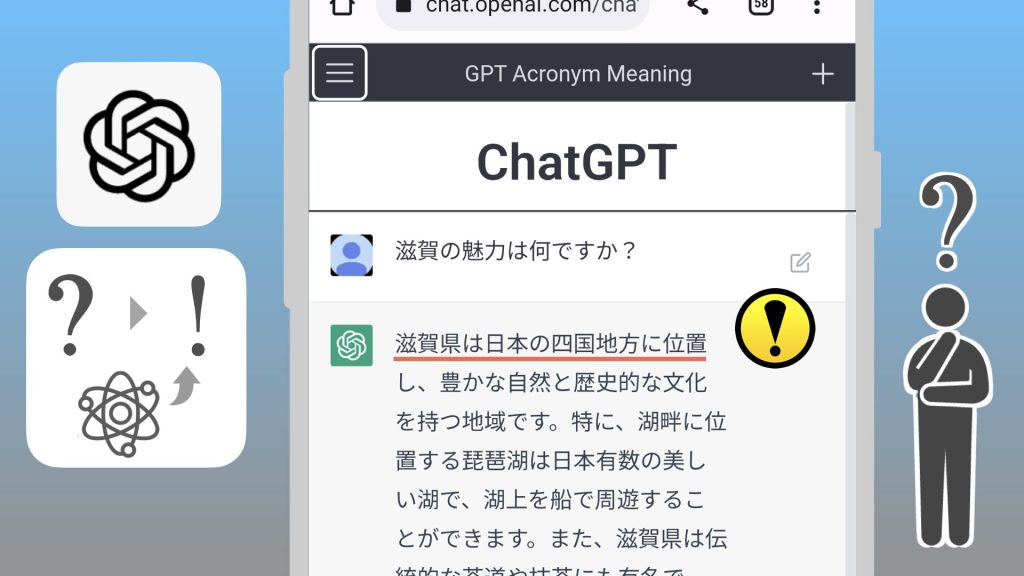

「ハルシネーション」の特徴は、「正しくない情報を自信ありげに言うこと」です(confidently state information that isn’t correct)1。

「インターネットには虚偽情報が含まれる」というのと、「生成AIの回答には虚偽情報が含まれる」というのは、似ているようでちょっと違う気がするね。

1. AIの「ハルシネーション」とは?

「ハルシネーション」は、AIが間違った情報を信じているような状態のことを言います。

例えば、こんな感じです。

- 明らかに間違った情報を事実として述べる

「東京タワーは北海道にあります」 - 存在しない人物や物事について詳しく語る

「山田太郎という有名な画家がいて、彼は〇〇という傑作を残しました」 - 現実にはありえない因果関係を説明する

「りんごを食べると必ず頭が良くなります」

なんかAIに言われると、つい そうなのかなぁって思っちゃうよ。

なんとなく「機械は間違えない」イメージだったから。

2. ダブルチェックをすること

ハルシネーションを避けるには、「ダブルチェック」が有効です。

重要な情報については、必ず複数の信頼できる情報源から確認するようにしましょう。

AIから得られる情報には、このように誤りが含まれている可能性があることを念頭に置き、批判的に考えることが大切です。

AIを使う際は、その出力内容を鵜呑みにせず、常に現実と照らし合わせて確認する必要がありますね。

3. なぜAIは「ハルシネーション」を起こすのか?

ハルシネーションは、膨大なデータのパターンを学習し、それにもとづいて新しい情報を生成するという仕組みに起因しています。

一つは、学習の不完全さの問題です。

AIの学習が不十分だったり、学習データに偏りがあったりすると、ハルシネーションが起こりやすくなります。

AIは学習する過程で、大量のデータを分析します。

しかし、そのデータの中には間違った情報も混ざっていることがあります。

また、AIがデータを解釈する過程で誤りが生じることもあります。

3.1. 「パターン学習から回答する」という必然

学習が進めばハルシネーションはなくなるの?

話はそう簡単ではありません。

AIにとっては、知らないことを「知らない」と言うのは難しいのです。

もちろん、ランダムの度合い(厳密さと創造性のバランス)は、パラメータによってある程度調整できます。

しかし、そもそも機械学習は既知の学習パターンから、未知の問題に対処するための仕組みです。

厳密さを重視しすぎると、AIはほとんどの回答を拒否してしまいます。

つまり、学習範囲を逸脱するのは必然なのです。

3.2. AIは事実を確認できない

また、AIには、事実を直接確認する手段がありません。

そのため、人間による「評価」が高い情報を生成するように改善しています。

AIにとっては、事実かどうかはあまり重要ではありません。

パターン学習によって生み出された文章は、人間から見ると「現実と乖離している」ということが往々にしてあります。

学習したデータの組み合わせの中で、それっぽい文章を生成しているだけなのです。

そもそも、デカルトみたいな哲学的に考えれば、人間も「事実をわかっている」とは言えないだろうけどね。

(補足)

- “those models infamously hallucinate knowledge — that is, confidently state information that isn’t correct” – Blender Bot 2.0(ai.meta.com)