話題になっている ChatGPT(chat.openai.com/chat) のアカウントを作成して、試してみました。

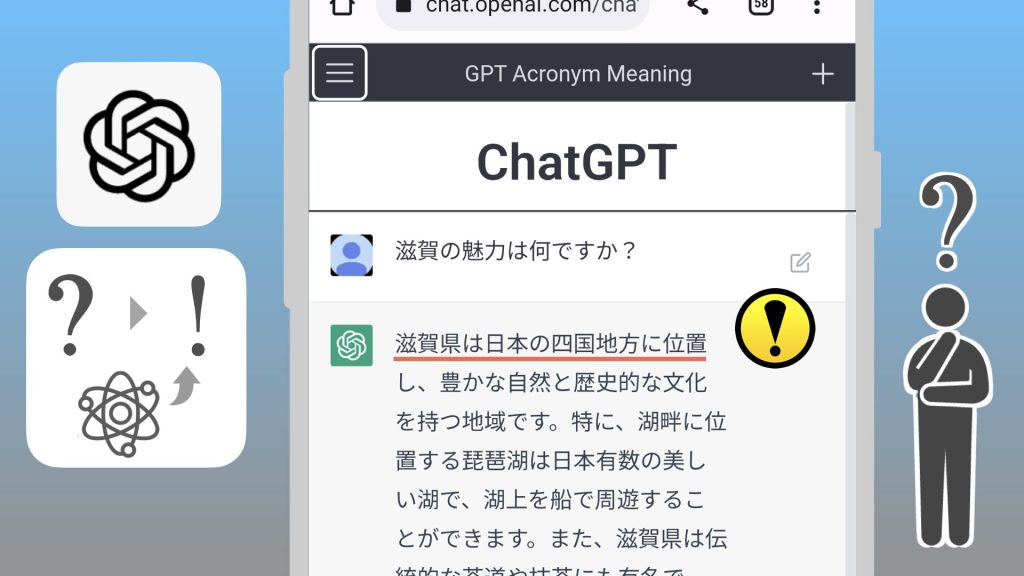

まるで人間が答えたような回答を、すぐに出すのでびっくりしました。しかし、いろんな回答をよく読んでみると「滋賀を四国地方」と言ってみたり、あからさまな間違いも少なくありません。

また、こちらから送った文章に機密事項が含まれている場合でも、ChatGPTはそれを学習して、別の人に回答してしまう可能性があります。

いよいよ「検索の次の時代」が見えてきました。

ただし、結局、受け取った情報を鵜呑みにせず、別の情報源でも確認する姿勢が大事なんですね。

ChatGPT GPT 3.0

1. ChatGPTは質問の答えを生成するAI

最近、いろいろな「人工知能(AI)」が話題です。

予めプログラムで決まった答えではなく、たくさんインプットした情報を総合して答えを作り出す仕組みを、「人工知能」と読んでいます。

「ChatGPT」は、OpenAIが開発したAIシステムで、与えられた文章の答えを返します。

1.1. 利用には会員登録(無料)が必要

ChatGPTを利用するには、会員登録が必要です。

メールアドレス、Googleアカウント、Microsoftアカウントから登録できます。

今回は、手軽な「Googleアカウントによるログイン(Continue with Google)」を選びました。

注意書きに、GoogleとOpenAIで連携される情報が書かれています。

続行するにあたり、Google はあなたの名前、メールアドレス、言語設定、プロフィール写真を openai.com と共有します。

あとは、「電話番号による認証(Verify your phone number)」です。

SMSで OpenAI API 認証コードが送られてくるので、画面に入力します。

電話番号が必須なんだね。

あとは、利用上の注意点を3項目確認したら、入力できる状態になります。

いずれ、製品化されたら有料になるのかな。

1.2. 「猫の魅力」を聞いてみた

LINEのように画面下部の入力欄があります。

質問文を入力し、「送信(紙飛行機)」します。

「猫は何でかわいいの?」

「猫の好きなことを200字にまとめて」などと聞いてみました。

猫は何でかわいいの?

猫は形状や毛質、 動きなどがかわいい理由になります。 また、 人間にとっての猫の独特な性格や行動もかわいい理由になります。

猫の好きなことを200字にまとめて

猫は寝ることが大好きで、一日中寝ることが多いです。しっぽを振ることで興奮や満足を表すことが好きです。グルーミングをすることでストレスを解消することが好きで、遊ぶことも大好きです。特に球や紙ねじ、紙くずなどを遊ぶことが好きです。狩りや獲物を追跡することも好きです。さらに、家族と一緒にいることも好きです。猫は人間にとっては特に優しい性格の猫も多いです、その為家族と一緒にいることが好きです。

2つ目の答えは、ちゃんと文字数194文字でした。

どんな質問にも、まるで人間が考えたように答えを返してくることに驚きます。

少しずつ文章が作られているように表示されるのは、「演出」な側面もあると思います。

一瞬で表示されると味気ないので。

これまでは人間が知識を学んだり、あるいはキーワード検索で調べたりしていたものが、人工知能を使うとかんたんに「答え」を得ることができるようになります。

1.3. そつないけれど、当たり障りない「マジメ君」

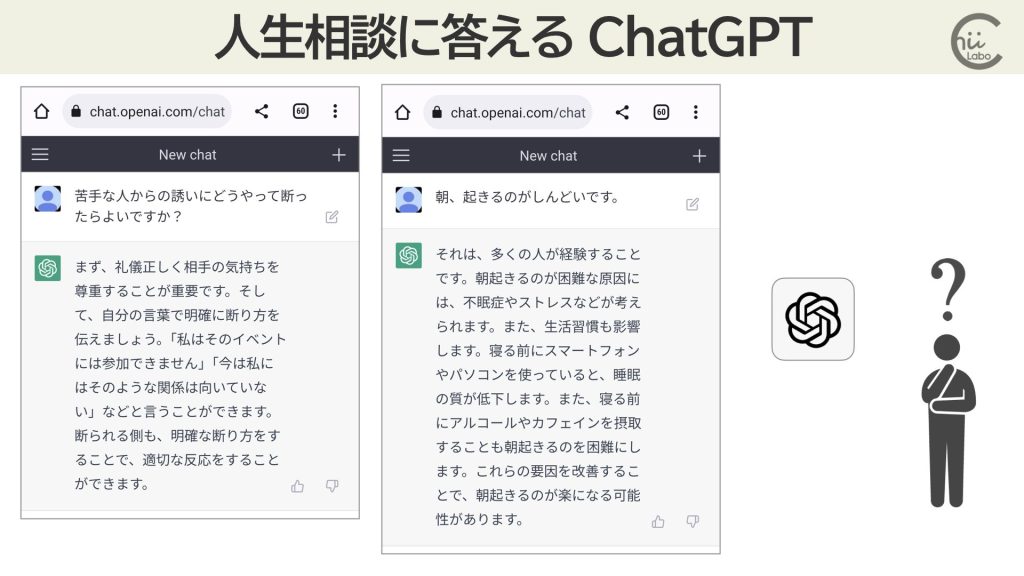

ほかには人生相談のような質問もしてみました。

苦手な人からの誘いにどうやって断ったらよいですか?

まず、礼儀正しく相手の気持ちを尊重することが重要です。そして、自分の言葉で明確に断り方を 伝えましょう。 「私はそのイベント には参加できません」「今は私に はそのような関係は向いていない」などと言うことができます。 断られる側も、 明確な断り方をすることで、 適切な反応をすることができます。

朝起きるのがしんどいです。

それは、多くの人が経験することです。朝起きるのが困難な原因には、不眠症やストレスなどが考えられます。また、生活習慣も影響します。寝る前にスマートフォンやパソコンを使っていると、睡眠の質が低下します。また、寝る前にアルコールやカフェインを摂取することも朝起きるのを困難にします。これらの要因を改善することで、朝起きるのが楽になる可能性があります。

言わんとすることはわかるけど、なんか正論すぎて「マジメ君」な印象もありますね。

要点を押さえた「そつない回答」なのですが、どうにも当たり障りない、というか。

まぁ、ロボットだからマジメだよね。

人は、相談に答えだけを求めているわけではないのですよね。

逆に、自分も人の相談に乗るときに、こういう回答をしていないか、反省させられました。

「正論を言うだけならAIでいい」という時代になりそうです。

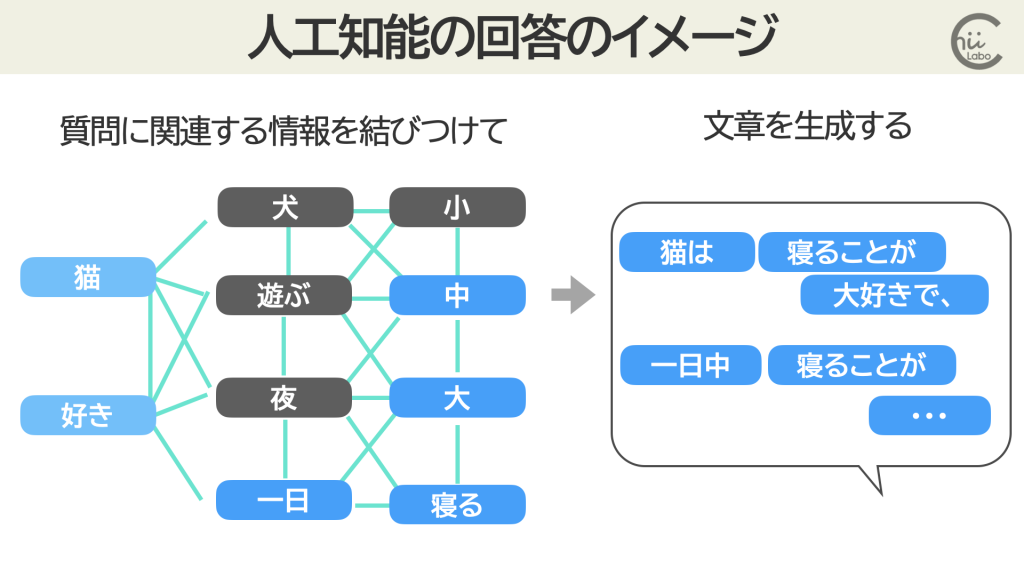

2. どうやって答えを作っているの?(深層学習)

人工知能は、どうやって答えを考えているの?

現実を体験している人間の「考える」とは、ちょっと違うかもしれません。

人工知能が返す答えは、どんなに確からしく見えても、基本的には情報の寄せ集め、「つぎはぎ」といえます。

まぁ、人間の脳も、本質的には電気信号の反応なのかもしれないですが……。

ChatGPTの「GPT」は、「生成的な事前学習のある、深層学習の言語処理系統」という意味です。

「深層学習」は、多層構造のニューラルネットワークの「重み付け」を調整して、正しいアウトプットに近づける手法です。

実際はもっと複雑ですが、かんたんにいうと、これまで書かれた膨大な文章を分解して、「関連性」を見つけます。これが「事前学習(Pre-trained)」です。

学習したAIは、質問を受け取ると、そのキーワードから関係する「知識」を組み合わせ、データにある既存の文と比較しながら、文章を再構成していきます。

ですので、なんとなくそれっぽい答えが出てきやすいのです。

2.1. 事前学習にないことは答えられない

逆にいうと、事前に情報を得ていないことは答えられません。

このChatGPTの研究試作版では、2021年までのデータしか学習していません。

それ以降の情報は知らないので、例えば「明日の天気」を聞いても、直接は回答できません。

明日の天気は?

私は2021年以降の天気データを持っていないため、明日の天気についてはお答えできません。 現在の日付は2023年1月24日です。 現在の天気については、天気予報サイトやアプリをご覧ください。

それでも、自分の限界と代替手段を伝えているのはさすがだね。

2.2. 一見 正しい答えに要注意

また、概念の関連付けは、失敗することもあります。

実際に知っていることを聞いてみると、けっこう明らかな「間違え」が見当たります。

例えば、「琵琶湖の大きさは?」と聞いてみたところ、「約619平方キロメートル」と答えたのです。

しかし、実際には、琵琶湖の面積は「約670平方キロメートル」です。

どこから「619平方キロメートル」が出てきたんだろう?

実は、琵琶湖大橋で南北に区切ると、

・北湖が「約618平方キロメートル」

・南湖が「約51平方キロメートル」

に分けることができます。

おそらく事前に学習した文章内に、「琵琶湖」、「面積」、「約619平方キロメートル」という言葉が同時に出てきたのでしょう。どうやら、それを「琵琶湖の面積」と混同してしまったようです。

本物っぽい情報なのに、正しくない情報が混ざっているので、かえって「厄介」かもしれません。

知らないことを聞いて、鵜呑みにするのはかなり危険ですね。

悪く言えば、「うろ覚えの受け売り」で答えている感じなんだね。

3. 人間とAIの付き合い方

もっと厄介なのは、このような「人工知能」の生成した文章と、人間の書いた文章は、見た目では区別がつかないことです。

すでに機械の生成した文章をもとにしたウェブサイトが多くあります。

もしかすると、検索して調べた結果が、AIの適当な文章かもしれないのです。

これは、人間が書いた文章ですけどね。

意味不明な機械の生成した文章を「ワードサラダ」と言ったりします。

AIが作った文章を、またAIが学習して、って繰り返していると、事実もわけわからなくなるかもね。

◆ すでにインターネット上には、プログラムが生成したような内容の薄いサイトは増えています。

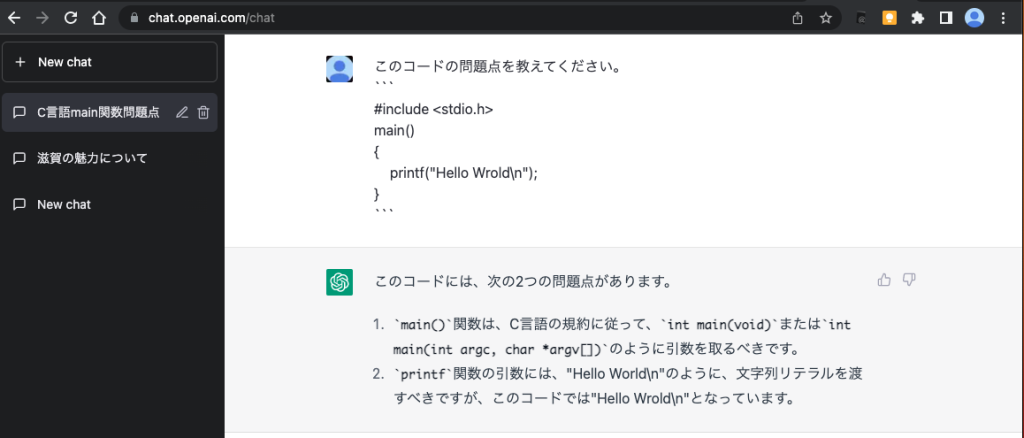

3.1. AIにプログラムを見てもらう(コードレビュー)

ChatGPTの使い方としては、はじめから質問するだけではありません。

自分の考えたものの問題点を指摘してもらうこともできます。

例えば、以下のようにプログラムを与えることで、改善点・問題点を指摘させることもできます。

このコードの問題点を教えてください。

```

#include <stdio.h>

main()

{

printf("Hello Wrold\n");

}

```

このコードには、次の2つの問題点があります。

1. main()関数は、C言語の規約に従って、int main(void)またはint main(int argc, char *argv[])のように引数を取るべきです。

2. printf関数の引数には、”Hello World\n”のように、文字列リテラルを渡すべきですが、このコードでは”Hello Wrold\n”となっています。

コンパイラのエラーや警告よりもわかりやすいね。

ちゃんとC言語のプログラムであることを認識して、答えています。

「絶対的な教師」とは言えなくても、「一つの相談相手」ぐらいに考えると、賢く付き合えるのかもしれませんね。

3.2. ChatGPTに送った文章は「学習」される

ただし、機密性のある情報は要注意です。

ChatGPTに送った文章やコードは、学習の材料になるからです。

仕事上のコードは、共有範囲を気をつける必要がありますね。

Amazonの極秘情報をChatGPTと共有しないようにとAmazon社員に向けてお達しがあったとのこと。ChatGPTがAmazonの社外秘であるはずのデータに非常に似たレスポンスを出したのをAmazon関係者が目撃したとし、社内での懸念が高まったようです。

Amazonが社員に注意喚起した「ChatGPTに共有してはいけないモノ」 | ギズモード・ジャパン

ネットで共有するのと一緒だね。

3.3. プロ棋士は将棋AIをどう使う?

相談相手としてAIを使う方法は、将棋の世界でも知られています。

オセロや将棋などの頭脳競技でも、AIが人間を凌駕するようになっています。

そこで将棋でも多くのプロ棋士が、「研究の道具」としてAIを利用するようになっています。

2014年、第3回電王戦では初めてソフトの事前貸し出しが行われ、ここまで強いのであればAIを道具として使うという発想が広がった。特に、第3回唯一の勝者となった豊島将之七段(当時)が、棋士たちとの研究会を去りAIによる独自の研究へとシフトしたことは、将棋界に大きな変化をもたらした。

“人知を超えた将棋AI“ 将棋界に学ぶ人とAIの共存の未来 | TRYETING Inc.(トライエッティング)

ただ、単純に「AIの言いなりで指す」というわけではないようです。

自分なりの考えにAIで「検討」させてみることで、研究を深めていくような使い方が主流です。

自分以外の視点を気軽に検討できるのは、便利ですね。

人同士だと日程を合わせる必要があるので。

また、今の深層学習によるAI は、勝手に学習して答えを出すため、「理由」を説明できない点という特徴があります。

AIには決定までのプロセスがブラックボックスであるという特徴がある。特にDL系は学習プロセスを追うことが不可能であり、最善手は示されるが、それが何故最善手なのかはAIは答えてくれない。人間は論理的な生物であるが故に、「何故」というプロセスを知ることにある種の充足感を得る。そこで最善手の論理的解明こそが、AIにはできず、人間である棋士にしかできないことではないだろうか。

また人間は、プロセスを納得することなく結果を受け入れることが難しい傾向を持っている。羽生九段は同じく著書の中で、「医療の現場でAIを使っていくときに、患者さんに『どうしてこの治療法をするんですか』と聞かれて、『理由はわかりませんが、確率的に高いからです」という説明だけで命を預けてもらうことができるでしょうか」と問いかける。

“人知を超えた将棋AI“ 将棋界に学ぶ人とAIの共存の未来 | TRYETING Inc.(トライエッティング)

つまり、AIは 人間の思考を(ある程度)補助してくれるでしょうが、その分 人間はさらに深く考えていくことが求められていくことになるのかもしれません。

こちらもどうぞ。

![[WordPress] 投稿月でグループ分けした月別PV集計表を見るためのカスタムプラグインを作った【ChatGPTと】](https://chiilabo.com/wp-content/uploads/2023/03/image-23-26-1024x576.jpg)